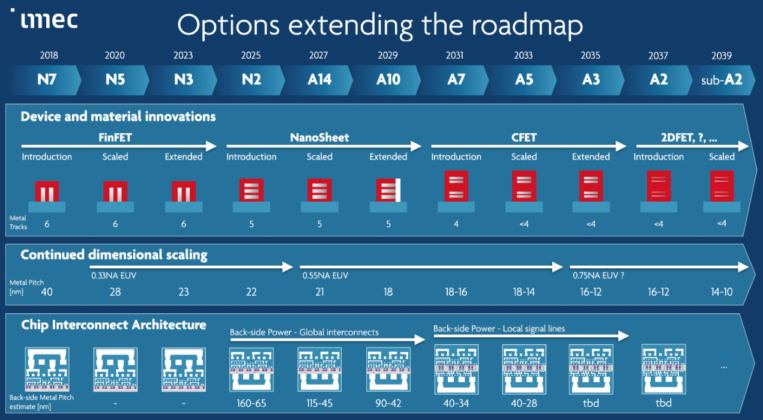

人工智慧(AI)與大型語言模型(LLM)的快速進展,模型的參數量呈現倍數成長,硬體設備亟需突破效能瓶頸。 面對龐大的算力需求,處理器供應商從CPU、GPU的運算效能、晶片內的資料傳輸頻寬等角度切入,盡可能滿足LLM在訓練與推論方面的效能需求。同時,企業導入生成式AI面臨諸多挑戰,包含模型更新速度飛快、數位分身(Digital Twin)如何導入,以及希望將Domain Know-how數據用於模型訓練,為企業提高生產效率等,都是企業AI面對的課題。

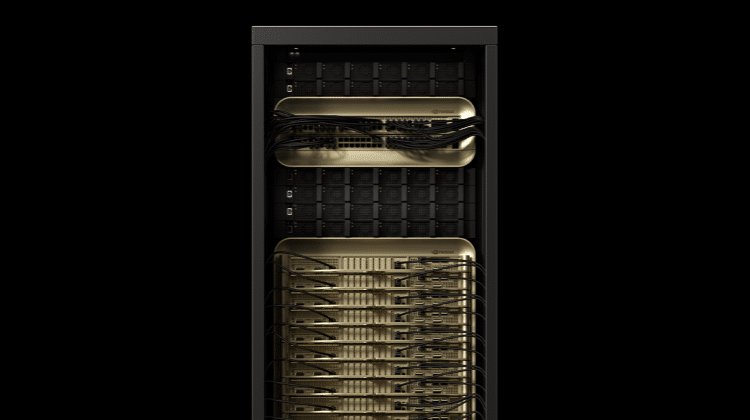

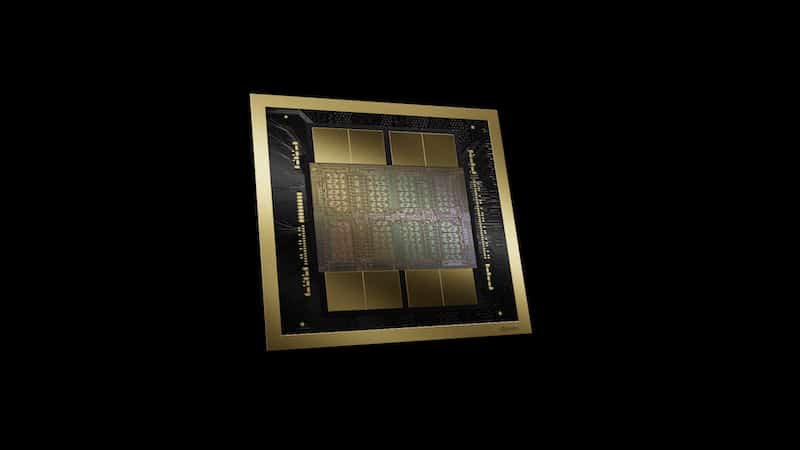

面對生成式AI大量的算力需求,NVIDIA 資深解決方案架構協理Eric Kang日前於台灣雲協「【NVIDIA GTC 2024】現身說法——探索AI 最新技術與未來發展」指出,因此NVIDIA在2024 GTC中,推出由一個CPU與兩個Blackwell GPU組成的GB200晶片,並透過NVLink串接多個處理器,以支援新一代演算法所需的算力。

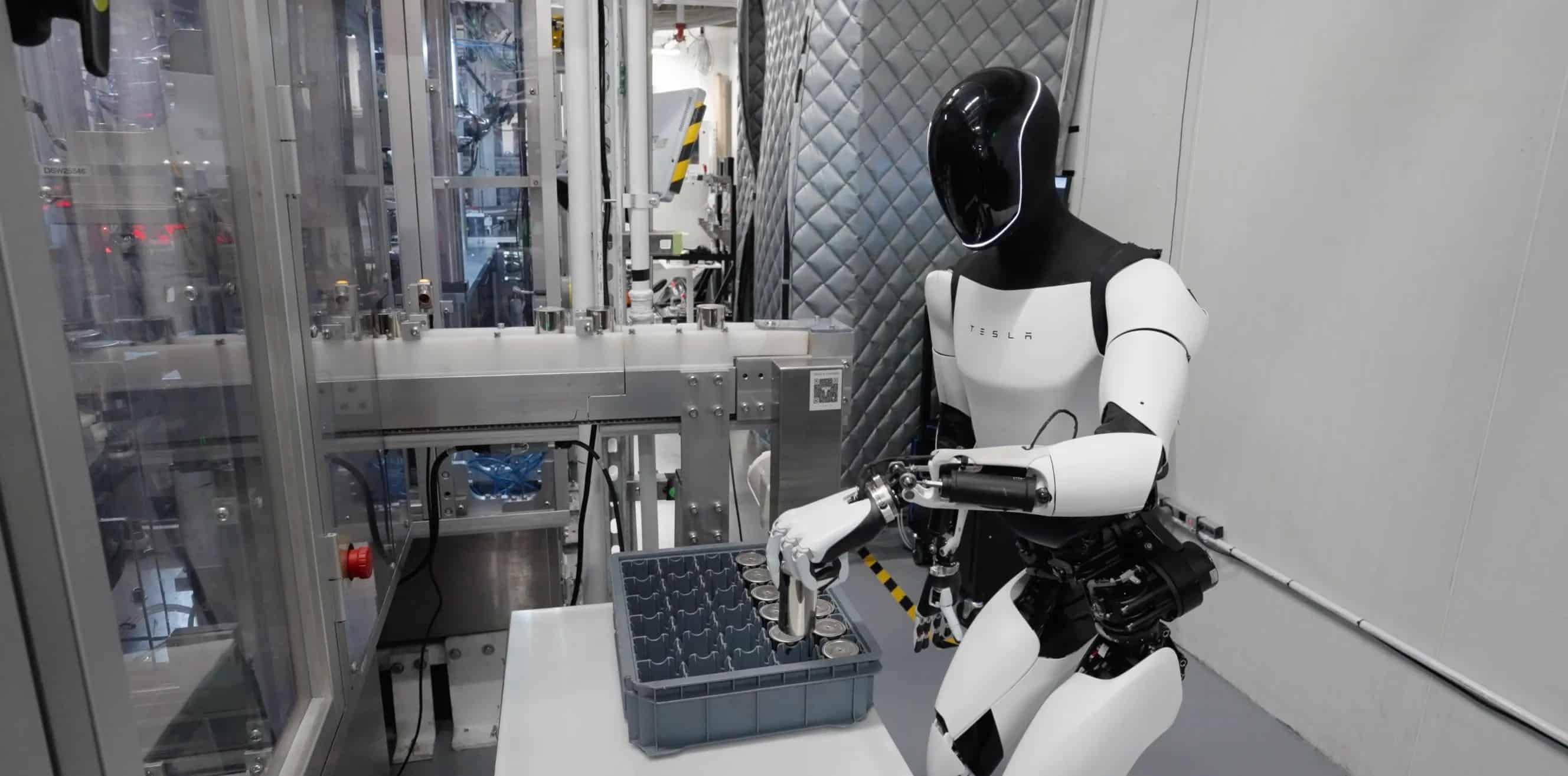

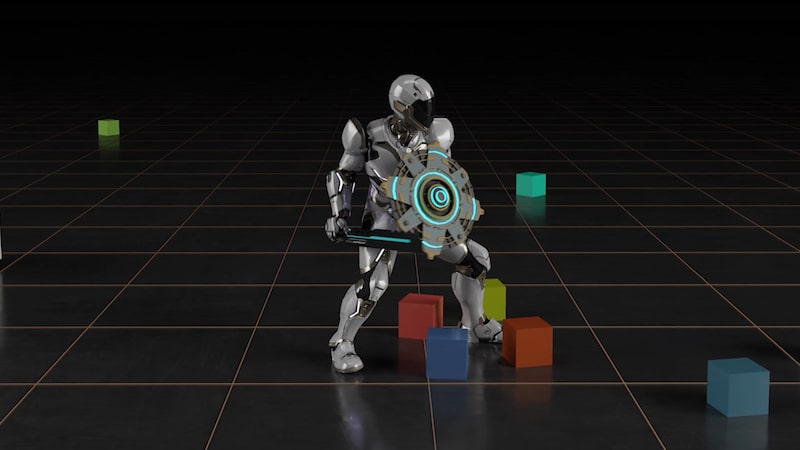

企業AI方面,數位分身成為企業數位轉型下的熱門應用。Eric提及,以伺服器製造商為例,製造商在工廠內可以過DGX導入數位分身,將AI模型結合產線的場景,用於產品的瑕疵檢測。同時,數位分身結合物聯網(IoT),在每個機台都能聯網的工廠內,採用AI模型管理產線,提高生產效率。所有主機的燒機測試、自動上架、下架,或是機房內硬體設備的擺放與散熱模擬,也能透過數位分身執行。

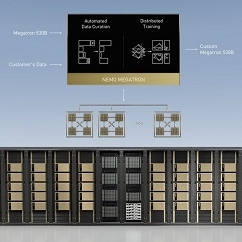

NVIDIA 資深資料科學家Andrew Liu表示,2024年是生成式AI的應用元年,企業將Domain Know-how用來訓練生成式模型,期望用來增加生產效率。然而企業在訓練模型並導入生成式AI的過程中,需要克服不斷有新的AI模型出現,軟體需要不斷更新的挑戰。而NVIDIA NIM是用於整合軟體的工具,可協助企業把模型導入在特定的GPU或基礎設施上,以順利執行LLM的推論、運作與更新。